DeepSeek

DeepSeek R1 系列及衍生蒸馏模型均为推理模型,且默认开启:reasoning_content 字段读取推理的思考链内容并显示:

推理模型通常不支持系统提示以及温度参数,因此在进行 API 调用的时候不要设置这两个参数。对于 DeepSeek 推理模型,还不支持函数调用及JSON输出功能,以及不支持

temperature、top_p、presence_penalty、frequency_penalty、logprobs、top_logprobs 参数。OpenAI

OpenAI 旗下的 o 系列和 GPT-5 系列模型均为推理模型,默认开启,且支持通过thinking.reasoning_effort 设置推理的努力程度,可选值有 none(GPT-5.1 开始支持)、minimal(GPT-5 开始支持)、 low、medium、high,默认为 medium(GPT 5.1 默认 none,即不开启推理):

<think> 和 </think> 标签包裹,并且和 AI 响应内容混在一起,这在流式响应中很难提取,为了降低开发者兼容成本,极客智坊所有推理模型思考链内容均兼容 DeepSeek 推理模型,都是从 AI 响应内容的 reasoning_content 字段获取(如果没有思考链,则对应字段值为空)。

如果使用的是

o3-mini-high、o4-mini-high 推理模型,则默认努力程度为 high,不需要额外单独设置。关于

thinking 配置的更多细节,请参考 API 手册说明。Claude

Claude 3.7 及更高版本模型(即 Claude 3.7、Claude 4.0、Claude 4.5 系列模型)才支持推理模式,支持推理模式的 Cluade 模型都是混合推理模型,需要通过设置thinking 配置项开启,以及配置用于思考的 tokens 预算:

max_tokens,则 budget_tokens 的值不能超过 max_tokens 的值。Claude 开启推理模式后不支持 temperature、top_p、top_k 参数设置。

Claude 推理模式思考链内容也兼容 DeepSeek 推理模型,通过 reasoning_content 字段获取。

如果使用的是带

-thinking 后缀的模型ID,则默认已开启推理模式,且 budget_tokens 值为 24000,可以 thinking 参数。如果你想要启用 Claude Sonnet 3.7 最大支持 128K 输出的实验特性,可以通过将

thinking.reasoning_effort 设置为 high 实现(仅 3.7 版本支持生效,其他版本会忽略该配置)。Gemini

Gemini 2.5 开始所有模型默认为推理模型,且默认开启,你可以通过将thinking.budget_tokens 设置为 0 关闭推理模式(对 Gemini 2.5 Pro 无效,因为其不支持关闭推理模式),以加速 AI 回复速度,如果你想要显示思考链内容,可以将 thinking.include_thoughts 设置为 true(默认 false 不显示思考链),还可以通过修改 thinking.budget_tokens 调节用于推理的最大 tokens 数,该数值越大,思考深度越深:

reasoning_content 字段获取。

仅 Gemini 2.5 系列模型支持

thinking.budget_tokens 参数,对于 Gemini 2.5 Pro 该参数值范围是 128-32768,如果未设置该参数,模型会自行决定,对于 Gemini 2.5 Flash,该参数值范围是 0-24576,0 表示关闭推理功能。如果使用的是名称带

:no-thinking 后缀的模型,则默认已关闭推理模式,且 budget_tokens 值为 0,可以不传递 thinking 参数。Grok 4

Grok 4 是 xAI 最新发布的、支持图片输入的视觉推理模型,默认开启推理模式,且目前不支持关闭,调用方式和 Grok 3 一致:reasoning_content 字段获取。

Qwen3

Qwen3 系列所有模型均为推理模式和非推理模式融合模型,且支持通过enable_thinking 参数切换(仅千问模型支持该参数),默认关闭:

qwen3-8b、qwen3-14b、qwen3-32b、qwen3-30b-a3b、qwen3-235b-a22b 均支持开源免费版本,加上 :free 后缀即可,你可以在模型广场进行筛选和查看。

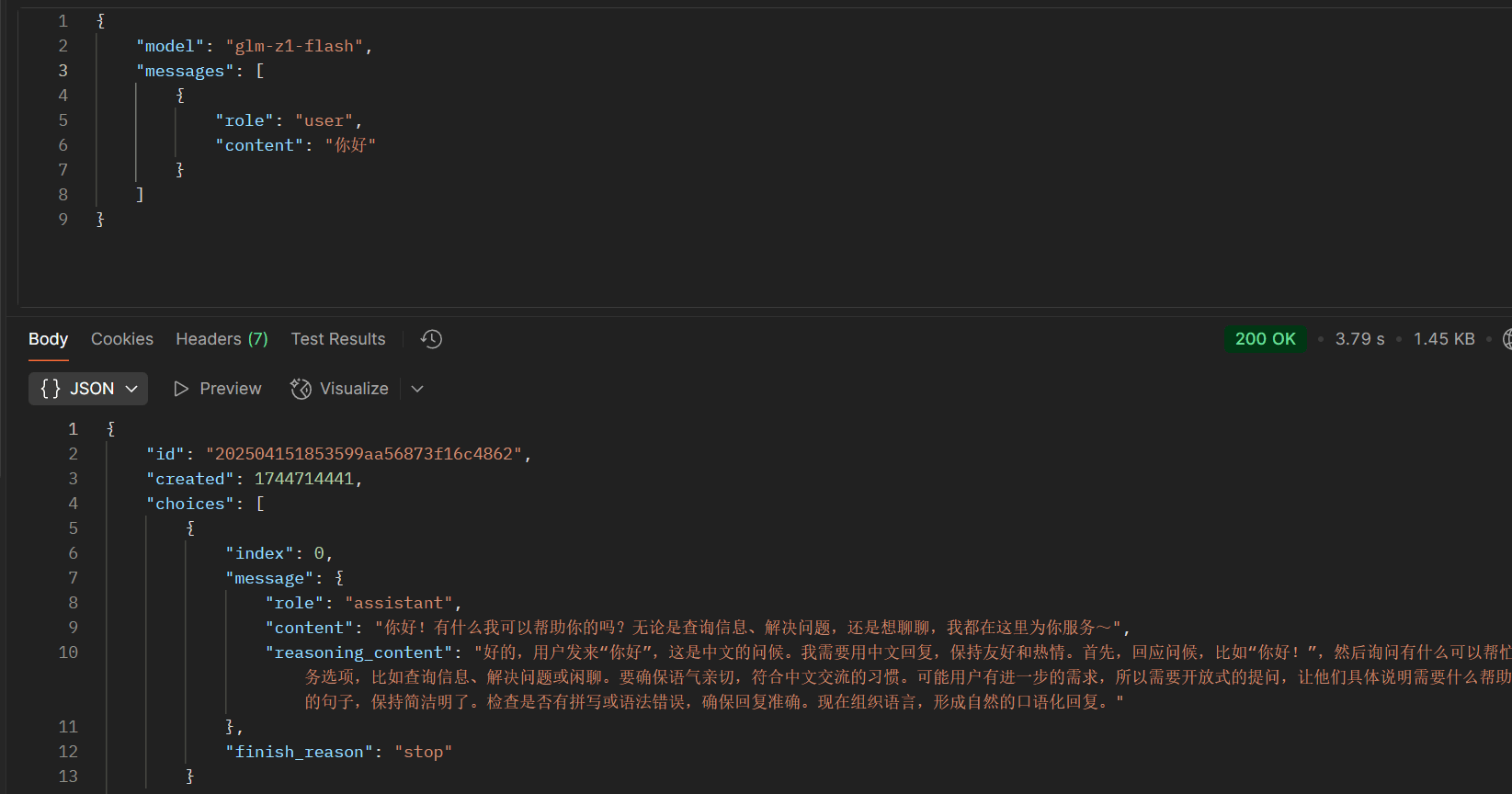

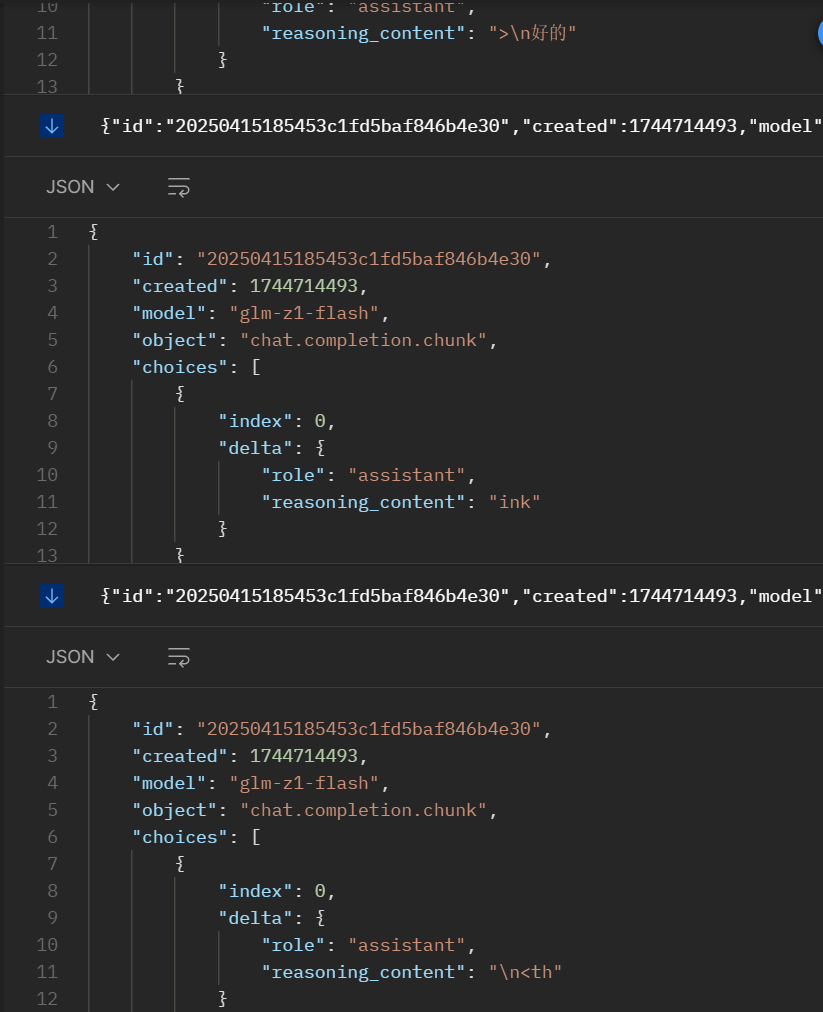

GLM 推理模型

GLM Z1、GLM 4.5、GLM 4.6 系列及衍生蒸馏模型均为推理模型,且默认开启:<think> 和 </think> 标签包裹,并且和 AI 响应内容混在一起,和 OpenAI 一样,极客智坊也使其兼容了 DeepSeek 推理模型,可以从 AI 响应内容的 reasoning_content 字段获取思考链内容并展示(如果没有思考链,则对应字段值为空):

- 非流式响应示例

- 流式响应示例

GLM-4.1V-Thinking 为支持图片/视频的视觉推理模型,同样默认开启推理模式,调用方式和 GLM Z1 系列一样,只不过新增对图片/视频输入的支持,且思考链内容也兼容 DeepSeek 推理模型,通过

GLM-4.1V-Thinking 为支持图片/视频的视觉推理模型,同样默认开启推理模式,调用方式和 GLM Z1 系列一样,只不过新增对图片/视频输入的支持,且思考链内容也兼容 DeepSeek 推理模型,通过 reasoning_content 字段获取思考链内容并展示(如果没有思考链,则对应字段值为空):

reasoning_content 字段获取思考链内容并展示(如果没有思考链,则对应字段值为空)。

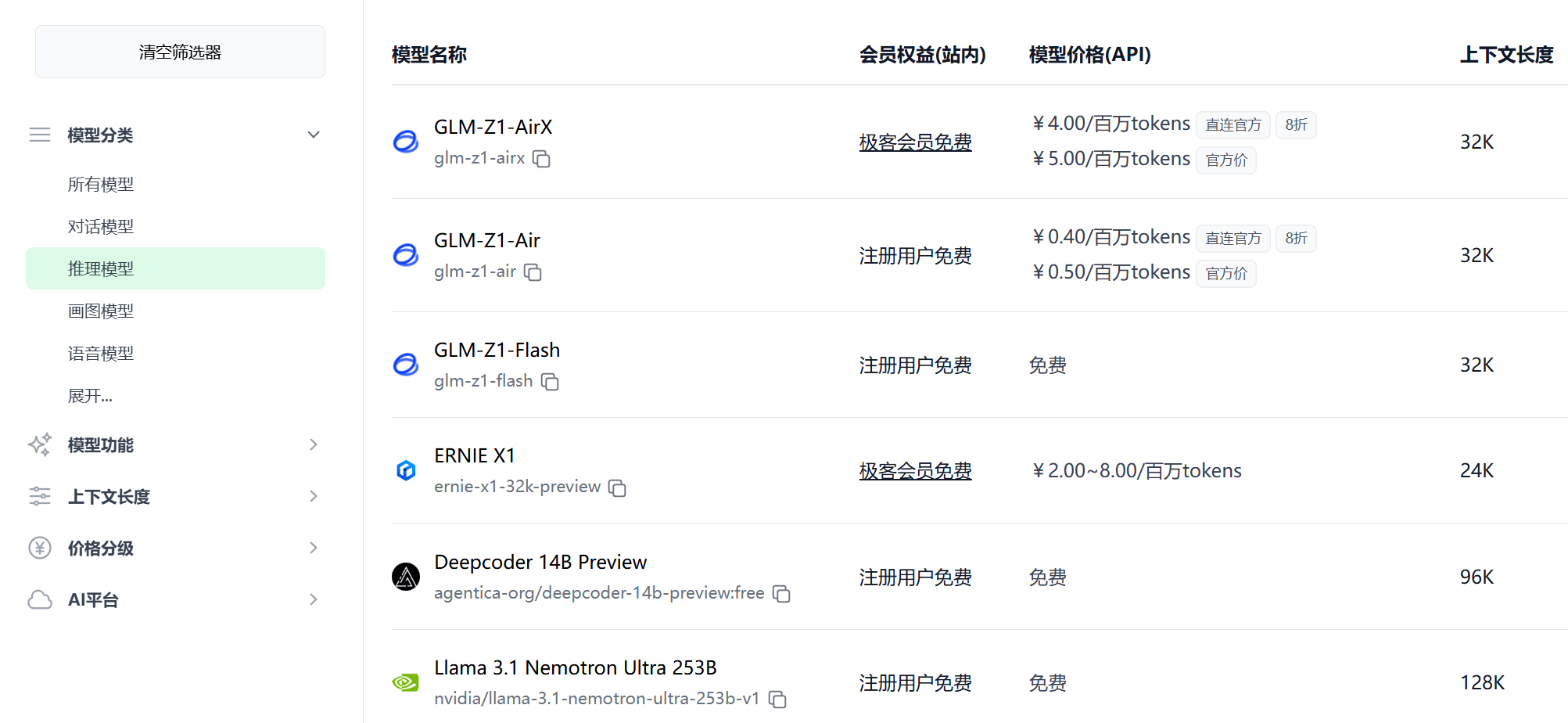

其他推理模型

除了上面列举的之外,还有很多其他支持推理模式的 AI 模型,如 Grok 3、Grok 4、通义 QwQ/QvQ、ERNIE X1、混元 T1 等,所有推理模型请求/响应参数兼容 DeepSeek,对于不兼容的推理模型,极客智坊底层会自动对齐。 需要注意的是,只有推理模型支持推理模式,你可以在模型广场查看极客智坊支持的所有推理模型,目前极客智坊已支持40多个推理模型,特定模型还支持联网推理以及深度推理,如 DeepSeek 联网推理版、DeepSeek 深度推理版、Grok 深度推理版等: 另外,推理模型通常不支持系统提示以及温度参数,因此在进行 API 调用的时候不要设置这两个参数。

另外,推理模型通常不支持系统提示以及温度参数,因此在进行 API 调用的时候不要设置这两个参数。