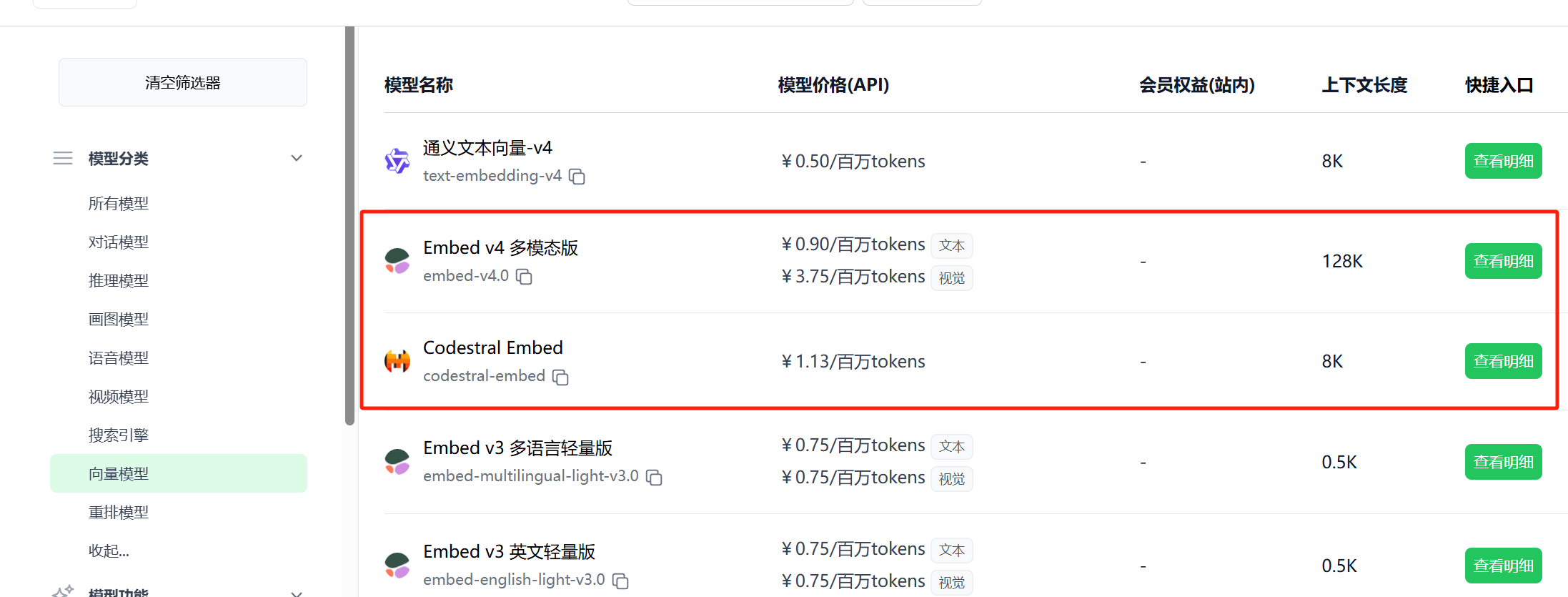

2025.05.30 支持 Codestral Embed & Cohere Embed v4

极客智坊已支持 Mistral AI 旗下专门用于代码向量化的模型 Codestral Embed 以及 Cohere AI 旗下最新多模态向量模型 Embed v4,你可以在模型广场进行查看和选用: 向量模型 API 调用示例请参考对应 API 使用文档。

向量模型 API 调用示例请参考对应 API 使用文档。

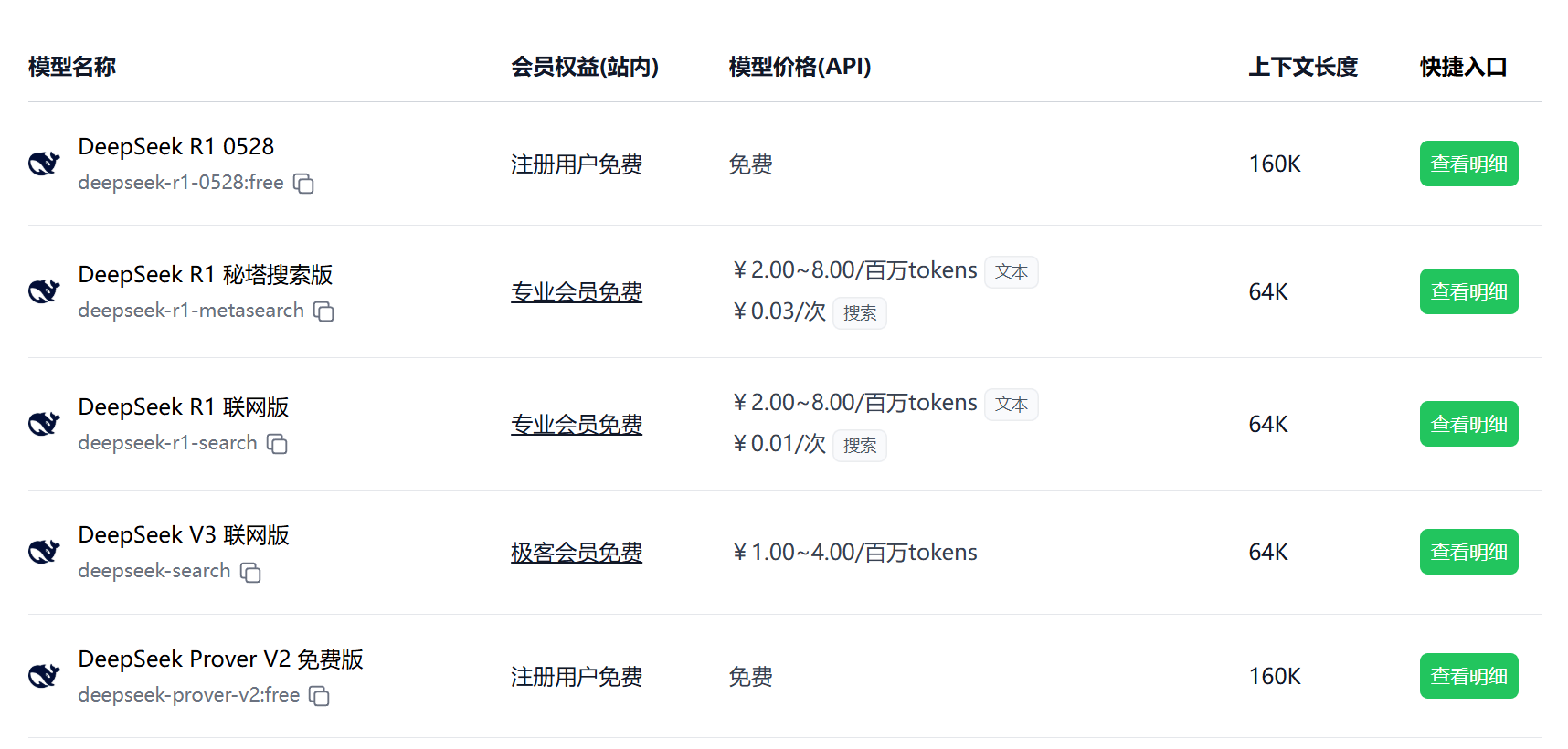

2025.05.29 支持 DeepSeek R1 0528

极客智坊已支持 DeepSeek 最新发布的 R1 0528 版本,性能与 OpenAI o1 相当,以及一个蒸馏模型 DeepSeek R1 0528 Qwen3 8B,欢迎体验👉

为降低用户调用 API 成本,极客智坊提供了完全免费的调用渠道,你可以在模型广场进行查看和选用:

极客智坊已支持 DeepSeek 最新发布的 R1 0528 版本,性能与 OpenAI o1 相当,以及一个蒸馏模型 DeepSeek R1 0528 Qwen3 8B,欢迎体验👉

为降低用户调用 API 成本,极客智坊提供了完全免费的调用渠道,你可以在模型广场进行查看和选用:

模型 API 调用示例请参考 API 使用文档。

模型 API 调用示例请参考 API 使用文档。

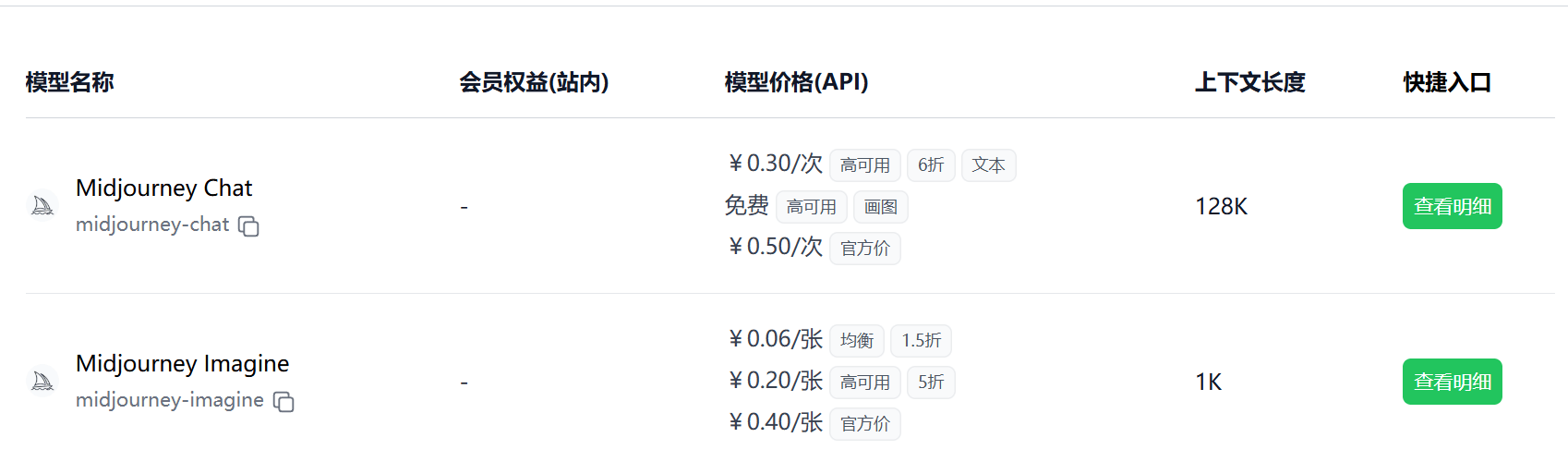

2025.05.28 支持 Midjourney Imagine & Chat

极客智坊已支持 Midjourney 画图模型 Imagine 模式和 Chat 模式,前者对标 GPT-Image-1,后者对标 GPT-4o-Image,其中 Imagine 模式支持切换 Relax、Fast、Turbo 三种模式(由慢到快),欢迎体验👉

为降低用户调用 Midjourney API 画图成本,极客智坊提供了多种不同的 Midjourney API 低价代理渠道,你可以在模型广场进行查看和选用:

极客智坊已支持 Midjourney 画图模型 Imagine 模式和 Chat 模式,前者对标 GPT-Image-1,后者对标 GPT-4o-Image,其中 Imagine 模式支持切换 Relax、Fast、Turbo 三种模式(由慢到快),欢迎体验👉

为降低用户调用 Midjourney API 画图成本,极客智坊提供了多种不同的 Midjourney API 低价代理渠道,你可以在模型广场进行查看和选用:

Imagine 模式下均衡对应 Relax 模式,高可用对应 Fast 模式,直连官方对应 Turbo 模式。

gpt-4o-image 模型,后者可类比 gpt-image-1 模型。

2025.05.23 支持 Claude 4 Sonnet & Opus

极客智坊已支持 Anthropic 最新发布的 Claude Opus 4 和 Claude Sonnet 4,它们在编码、高级推理和 AI 代理方面树立了新的标杆:

极客智坊已支持 Anthropic 最新发布的 Claude Opus 4 和 Claude Sonnet 4,它们在编码、高级推理和 AI 代理方面树立了新的标杆:

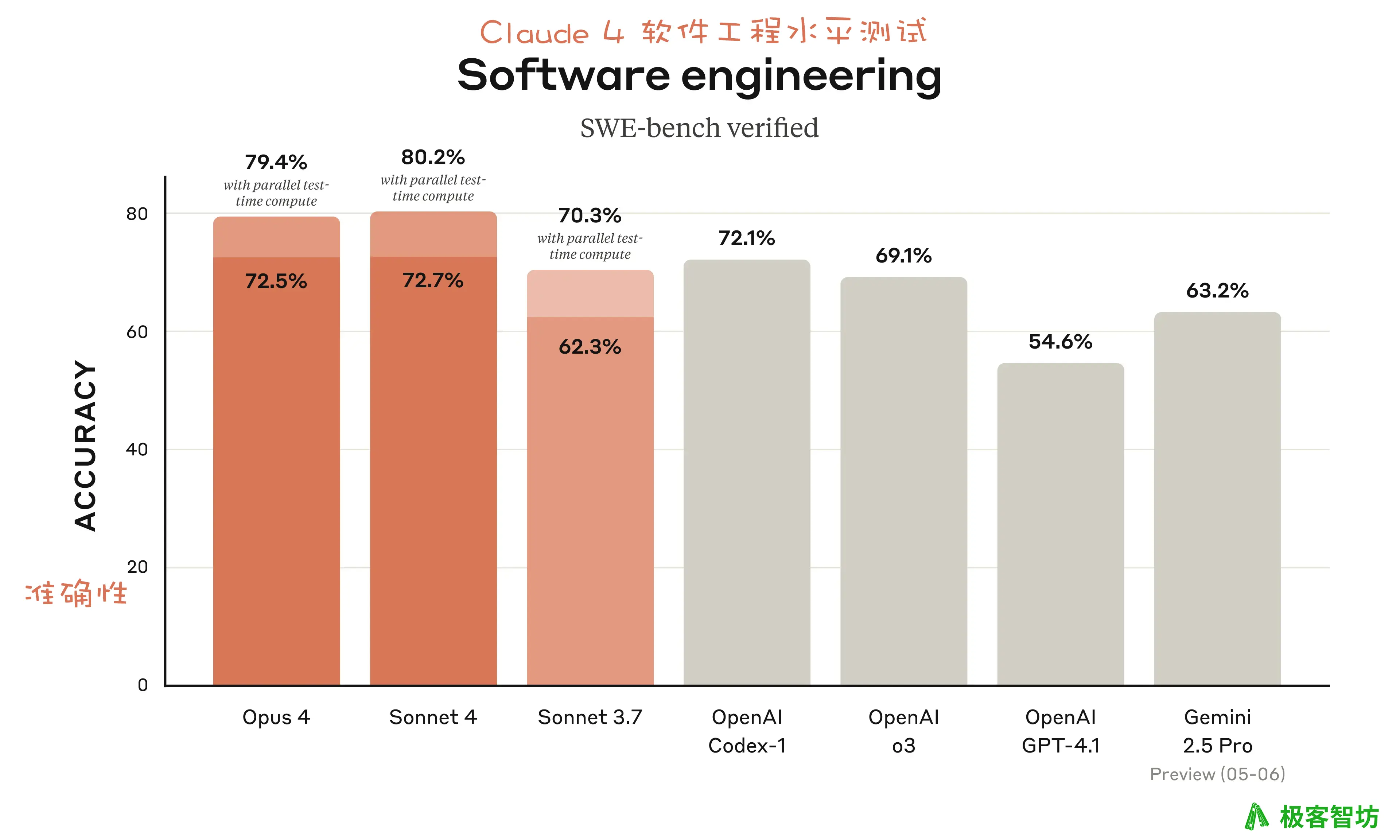

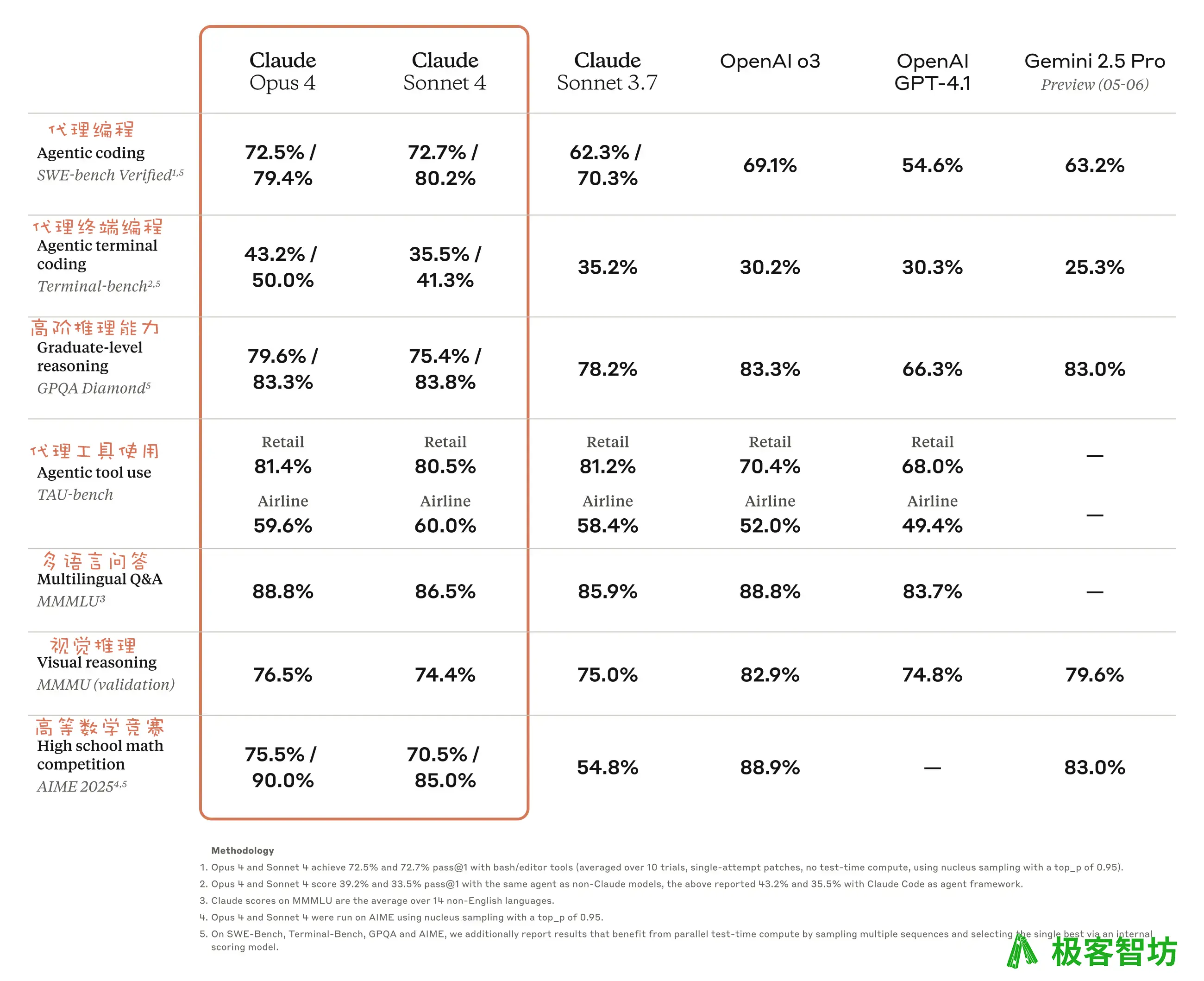

- Claude Opus 4 是我们迄今为止最强大的模型,也是全球顶尖的编码模型,在 SWE-bench (72.5%) 和 Terminal-bench (43.2%) 基准测试中均名列前茅。它在需要专注和数千步骤的长时间任务中表现出色,能够持续工作数小时,远超所有 Sonnet 模型,并显著提升了 AI 代理的能力。

- Claude Sonnet 4 在 Sonnet 3.7 行业领先的基础上有了显著提升,尤其在编码方面表现出色,在 SWE-bench 基准测试中达到了 72.7% 的顶尖水平。该模型兼顾了性能和效率,适用于各种内部和外部应用场景,并增强了可控性,从而更好地管理具体实施。虽然在多数领域不如 Opus 4,但它在能力和实用性之间实现了最佳平衡。

欢迎体验👉

欢迎体验👉

- Claude Sonnet 4 体验入口

- Claude Opus 4 体验入口

- Claude Sonnet 4 推理版体验入口:在 Claude Sonnet 4 基础上自动开启推理模式,其他和标准版一样

- Claude Opus 4 推理版体验入口:在 Claude Opus 4 基础上自动开启推理模式,其他和标准版一样

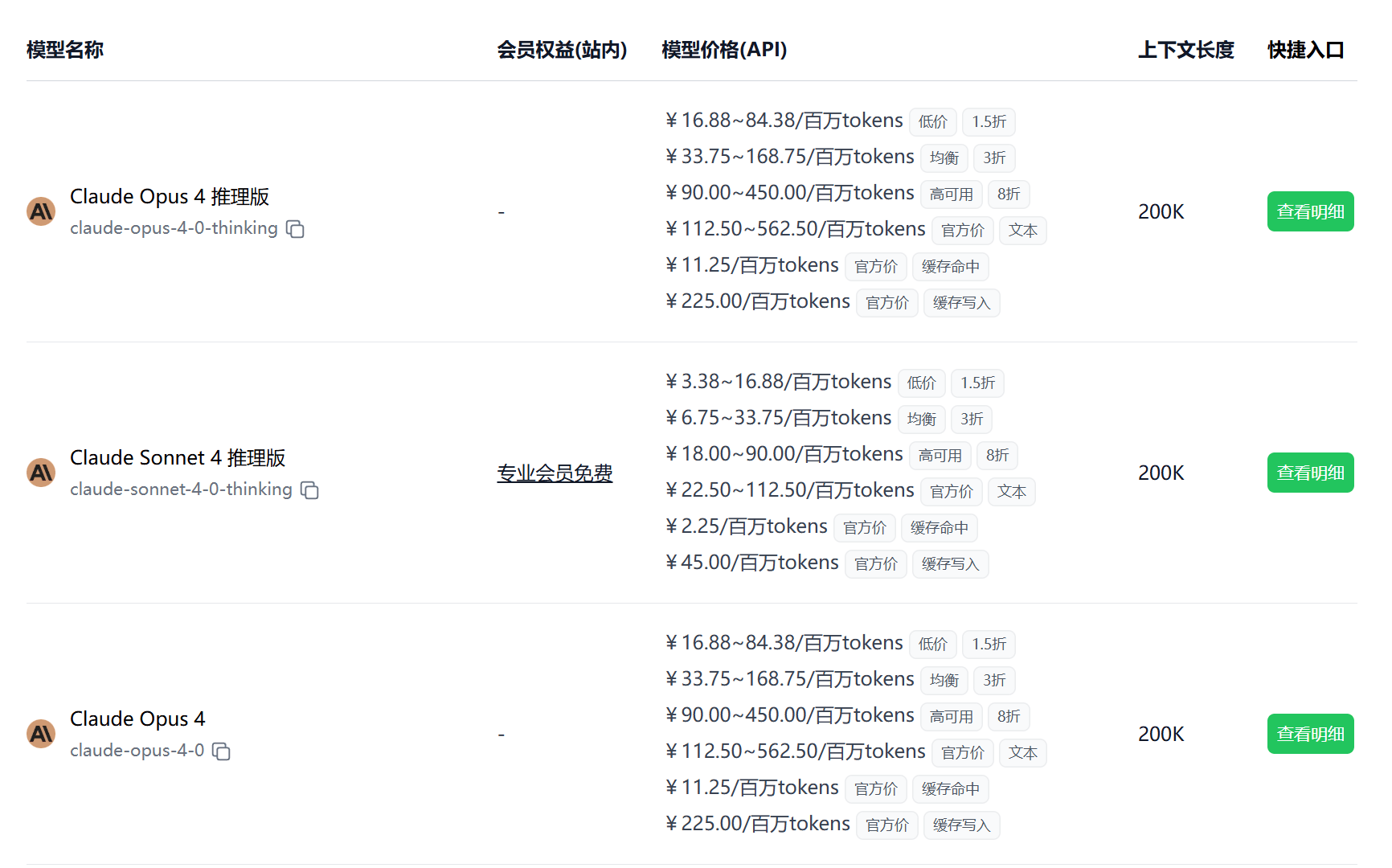

站内使用的话,购买专业版会员即可无限畅享 Claude Sonnet 4,同时每月获取 100 次 Claude Opus 4 免费体验次数。

如果在 Cursor 中使用,可以通过

站内使用的话,购买专业版会员即可无限畅享 Claude Sonnet 4,同时每月获取 100 次 Claude Opus 4 免费体验次数。

如果在 Cursor 中使用,可以通过 geekai-coder 和 geekai-coder-thinking 模型进行转发调用,该别名已指向最新版 Claude Sonnet,具体使用方法请参考这里。

2025.05.22 支持 DeepSeek V3 & R1 联网版及秘塔深度搜索

极客智坊今天新上了三个 DeepSeek 联网模型,分别是 V3 联网版,R1 联网版,以及秘塔深度搜索版,基于 DeepSeek 开源模型部署+联网搜索工具实现,欢迎体验👉

所有模型支持通过极客智坊 API 进行调用,你可以在模型广场进行查看和选用,模型 API 调用示例请参考 API 使用文档。

基础模型对话费用和 DeepSeek V3&R1 同价,V3 联网版搜索免费,R1 联网版搜索仅需 0.01 元/次,秘塔深度搜索版仅需 0.03 元/次,是目前全网最便宜的深度搜索模型,其他原生支持深度搜索的模型搜索价格普遍在几毛钱到几块钱不等。

极客智坊今天新上了三个 DeepSeek 联网模型,分别是 V3 联网版,R1 联网版,以及秘塔深度搜索版,基于 DeepSeek 开源模型部署+联网搜索工具实现,欢迎体验👉

所有模型支持通过极客智坊 API 进行调用,你可以在模型广场进行查看和选用,模型 API 调用示例请参考 API 使用文档。

基础模型对话费用和 DeepSeek V3&R1 同价,V3 联网版搜索免费,R1 联网版搜索仅需 0.01 元/次,秘塔深度搜索版仅需 0.03 元/次,是目前全网最便宜的深度搜索模型,其他原生支持深度搜索的模型搜索价格普遍在几毛钱到几块钱不等。

2025.05.21 支持最新版 Gemini 2.5 Flash 及 Gemma 3n E4B

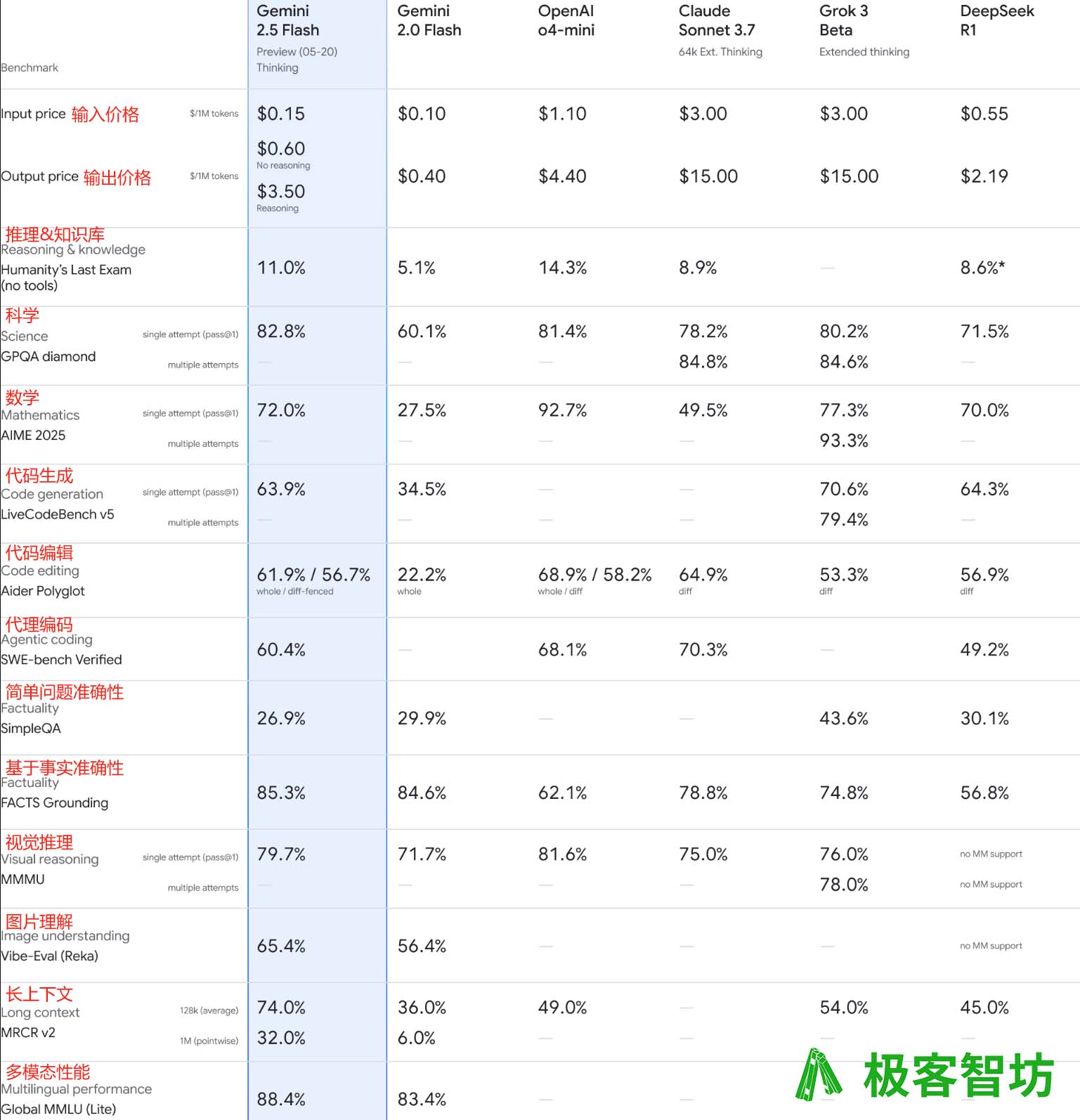

Google 于昨天 Google I/O 2025 大会上发布了最新版本的 Gemini 2.5 Flash 模型(专为高效、速度和低成本设计的轻量级推理模型),该版本在多个维度上有了显著提升,尤其在推理、多模态、代码和长文本处理等关键基准测试中表现优异,同时效率更高,评估中使用的 tokens 数量也减少了 20-30%:

Google 于昨天 Google I/O 2025 大会上发布了最新版本的 Gemini 2.5 Flash 模型(专为高效、速度和低成本设计的轻量级推理模型),该版本在多个维度上有了显著提升,尤其在推理、多模态、代码和长文本处理等关键基准测试中表现优异,同时效率更高,评估中使用的 tokens 数量也减少了 20-30%:

可以看到

可以看到 gemini-2.5-flash-preview-05-20 性能和 DeepSeek R1、o4-mini 以及 Claude-3.7-Sonnet 等模型相当,而价格却是最便宜的,此外 Gemini 2.5 Flash 还支持隐式缓存功能,命中缓存的提示输入价格为正常输入价格的 1/4,从而进一步降低成本,以及长达 1024K 的上下文长度,原生支持图片、音视频、PDF 文件对话,欢迎体验:

- Gemini 2.5 Flash 最新版体验入口

- Gemini 2.5 Flash 标准版体验入口,在 Gemini 2.5 Flash 最新版基础上关闭推理模式,从而提高模型响应速度以及降低模型输出成本,你可以在极客智坊站内免费使用该模型(不含API调用)。

- Gemma 3n E4B 免费版体验入口(API 调用也是免费的)

2025.05.12 支持 Gemini 隐式缓存

Gemini 2.5 模型现已支持隐式缓存功能,相较于之前需要显示创建缓存的方式,隐式缓存可以在不需要开发者干预的情况下自动缓存模型提示输入,从而达到降低模型使用成本的目的,而且免除了缓存存储的成本。

隐式缓存目前仅适用于 Gemini 2.5 版本模型,命中缓存的提示输入价格为正常输入价格的 1/4,你可以到模型广场进行查看和选用:

Gemini 2.5 模型现已支持隐式缓存功能,相较于之前需要显示创建缓存的方式,隐式缓存可以在不需要开发者干预的情况下自动缓存模型提示输入,从而达到降低模型使用成本的目的,而且免除了缓存存储的成本。

隐式缓存目前仅适用于 Gemini 2.5 版本模型,命中缓存的提示输入价格为正常输入价格的 1/4,你可以到模型广场进行查看和选用:

和 OpenAI 和 DeepSeek 提示缓存技术类似,两个请求间只有重复的提示前缀部分才能触发缓存命中,因此,为了增加请求命中缓存的几率,请确保请求开头的内容保持一致,并在提示的末尾添加用户提问或其他可能随请求变化的额外上下文。

缓存默认开启,对于 Gemini 2.5 Flash,适用于 1024 tokens 或更长的提示,对于 Gemini 2.5 Pro,适用于 2048 tokens 或更长的提示。

更多关于在 Gemini API 中使用隐式缓存的实用技巧,请参阅官方文档。

和 OpenAI 和 DeepSeek 提示缓存技术类似,两个请求间只有重复的提示前缀部分才能触发缓存命中,因此,为了增加请求命中缓存的几率,请确保请求开头的内容保持一致,并在提示的末尾添加用户提问或其他可能随请求变化的额外上下文。

缓存默认开启,对于 Gemini 2.5 Flash,适用于 1024 tokens 或更长的提示,对于 Gemini 2.5 Pro,适用于 2048 tokens 或更长的提示。

更多关于在 Gemini API 中使用隐式缓存的实用技巧,请参阅官方文档。

2025.05.08 支持 Mistral Medium 3

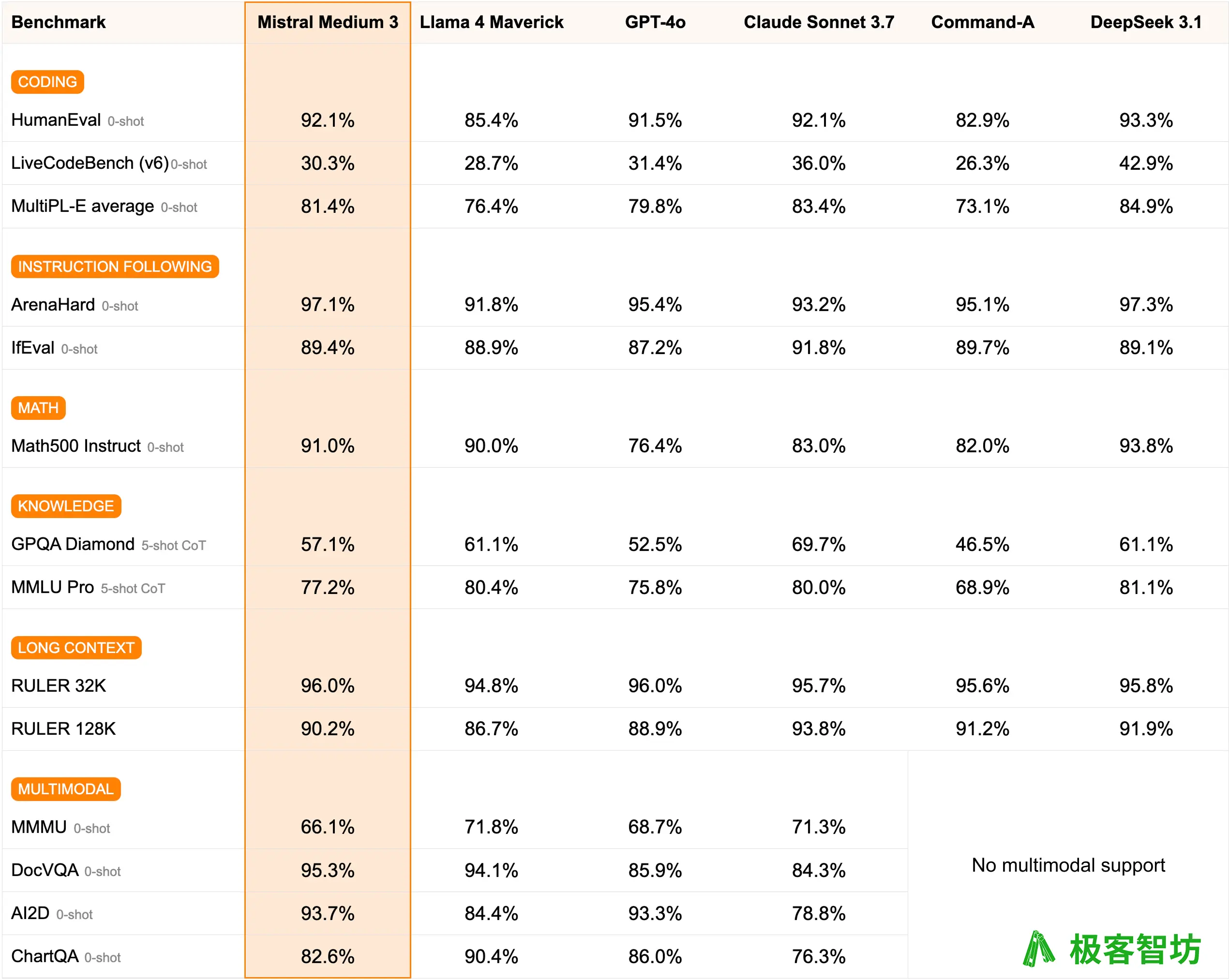

极客智坊已引入对 MistralAI 公司最新发布的企业级 AI 模型 Mistral Medium 3 的支持,Mistral Medium 3 性能卓越,同时成本大幅降低,在各项基准测试中,该模型的表现达到或超过 GPT-4o 和 Claude-3.7-Sonnet,但成本却大幅降低(每百万 token 的输入成本为 0.4 美元,输出成本为 2 美元)。在性能上,Mistral Medium 3 还超过了 Llama 4 Maverick 等领先的开源模型,以及 Cohere Command A 等企业级模型:

极客智坊已引入对 MistralAI 公司最新发布的企业级 AI 模型 Mistral Medium 3 的支持,Mistral Medium 3 性能卓越,同时成本大幅降低,在各项基准测试中,该模型的表现达到或超过 GPT-4o 和 Claude-3.7-Sonnet,但成本却大幅降低(每百万 token 的输入成本为 0.4 美元,输出成本为 2 美元)。在性能上,Mistral Medium 3 还超过了 Llama 4 Maverick 等领先的开源模型,以及 Cohere Command A 等企业级模型:

欢迎体验👉

该模型支持通过极客智坊 API 进行调用,你可以在模型广场进行查看和选用。

欢迎体验👉

该模型支持通过极客智坊 API 进行调用,你可以在模型广场进行查看和选用。

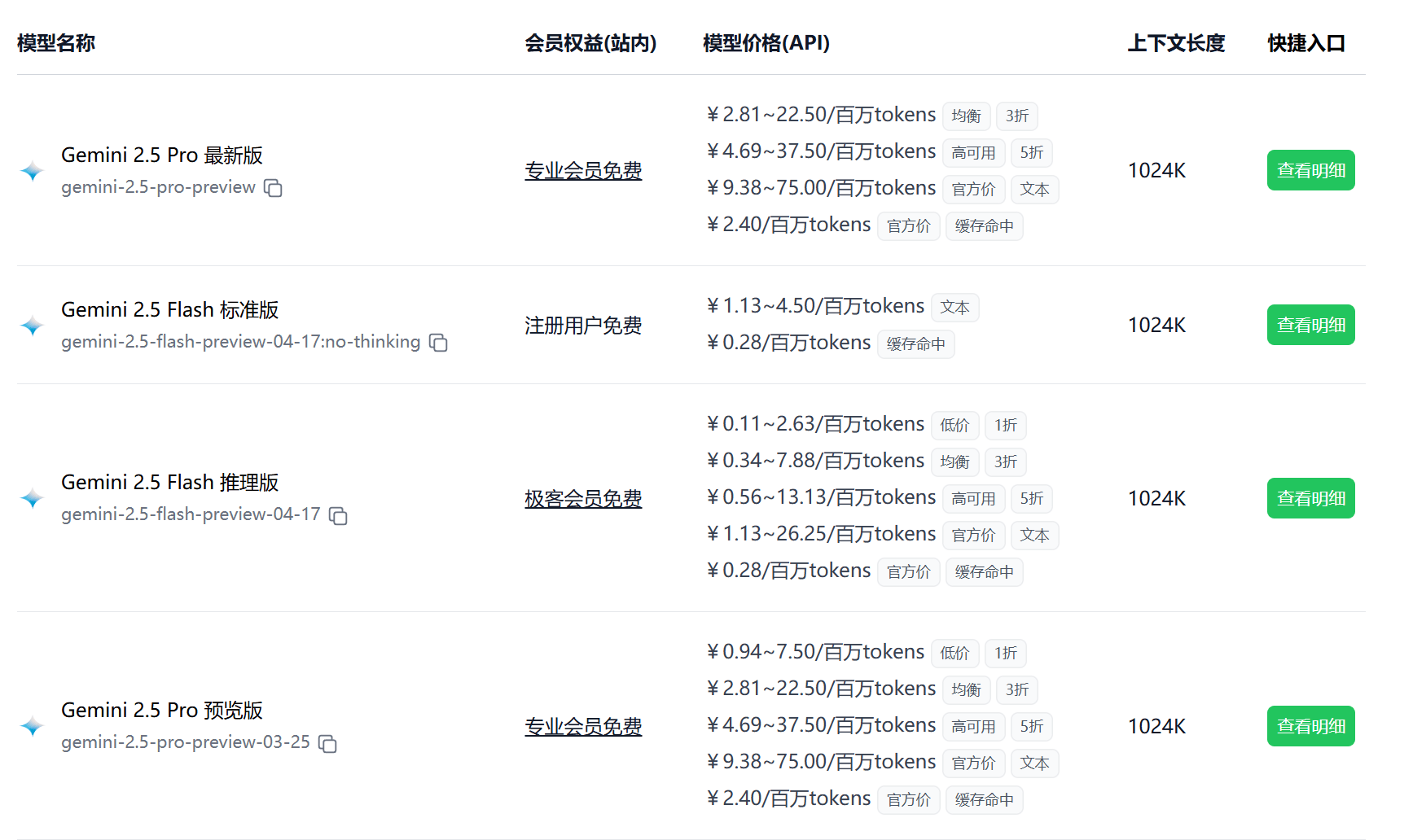

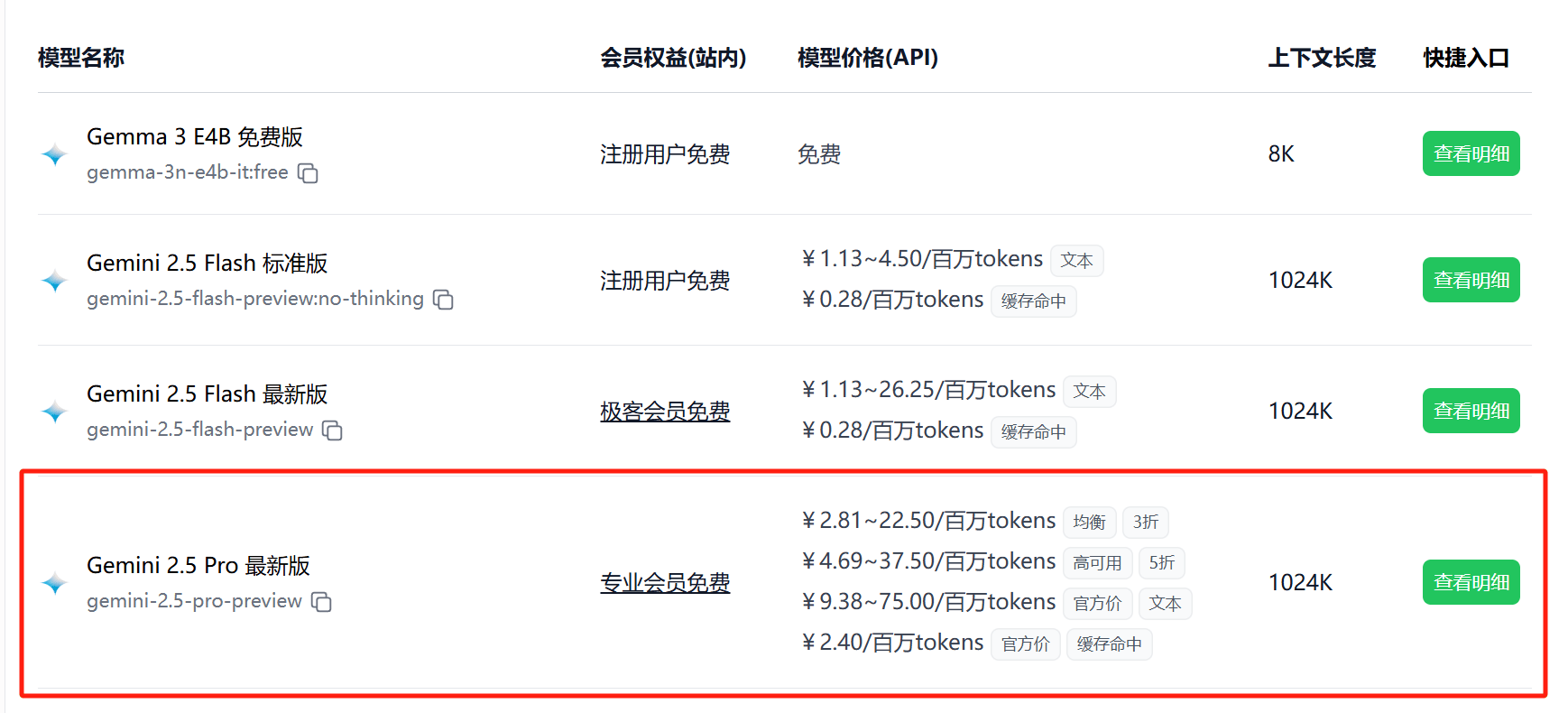

2025.05.07 支持 Gemini 2.5 Pro 0506 版

极客智坊已支持 Google 最新发布的 Gemini 2.5 Pro 预览版(0506),该版本在代码能力上有了显著提升,尤其是在构建构建更丰富、互动性更强的 Web 应用方面,同时,它还在原生的多模态和长文本处理方面持续进步,并在视频理解方面表现出色。

通过整合与教育专家共同开发的 LearnLM 模型系列,Gemini 2.5 Pro 已成为领先的学习模型。在教学法和有效性的对比评估中,教育工作者和专家在各种场景下都更倾向于选择 Gemini 2.5 Pro,而非其他模型。

欢迎体验👉

为了降低用户调用 Gemini 2.5 Pro API 成本,极客智坊还提供了不同渠道的折扣优惠,最低可至 1 折,站内使用的话,购买专业版会员即可无限畅享:

极客智坊已支持 Google 最新发布的 Gemini 2.5 Pro 预览版(0506),该版本在代码能力上有了显著提升,尤其是在构建构建更丰富、互动性更强的 Web 应用方面,同时,它还在原生的多模态和长文本处理方面持续进步,并在视频理解方面表现出色。

通过整合与教育专家共同开发的 LearnLM 模型系列,Gemini 2.5 Pro 已成为领先的学习模型。在教学法和有效性的对比评估中,教育工作者和专家在各种场景下都更倾向于选择 Gemini 2.5 Pro,而非其他模型。

欢迎体验👉

为了降低用户调用 Gemini 2.5 Pro API 成本,极客智坊还提供了不同渠道的折扣优惠,最低可至 1 折,站内使用的话,购买专业版会员即可无限畅享:

你可以在模型广场进行查看和选用,模型 API 调用示例请参考 API 使用文档。

你可以在模型广场进行查看和选用,模型 API 调用示例请参考 API 使用文档。

2025.05.02 支持 DeepSeek Prover V2

极客智坊已支持 DeepSeek Prover V2 模型 671B 参数版,这是一个为 Lean 4 形式定理证明设计的开源大型语言模型,其初始化数据是通过由 DeepSeek-V3 驱动的递归定理证明管道收集的,冷启动训练过程首先提示 DeepSeek-V3 将复杂问题分解成一系列子目标,已解决的子目标的证明被合成成一个思维链过程,结合 DeepSeek-V3 的逐步推理,为强化学习创建一个初始冷启动,这个过程使我们能够将非正式和正式的数学推理整合到一个统一模型中。

欢迎体验👉

所有模型支持通过极客智坊 API 进行调用,你可以在模型广场进行查看和选用。更多关于 API 调用和第三方应用接入的细节,请查阅极客智坊文档教程。

极客智坊已支持 DeepSeek Prover V2 模型 671B 参数版,这是一个为 Lean 4 形式定理证明设计的开源大型语言模型,其初始化数据是通过由 DeepSeek-V3 驱动的递归定理证明管道收集的,冷启动训练过程首先提示 DeepSeek-V3 将复杂问题分解成一系列子目标,已解决的子目标的证明被合成成一个思维链过程,结合 DeepSeek-V3 的逐步推理,为强化学习创建一个初始冷启动,这个过程使我们能够将非正式和正式的数学推理整合到一个统一模型中。

欢迎体验👉

所有模型支持通过极客智坊 API 进行调用,你可以在模型广场进行查看和选用。更多关于 API 调用和第三方应用接入的细节,请查阅极客智坊文档教程。