2025.07.30 支持 GLM 4.5 系列模型

极客智坊已支持智谱清言最新发布的 GLM 4.5 系列模型,包括开源模型和商业模型,GLM-4.5 系列是智谱清言面向智能体时代打造的最新旗舰模型,全面升级理解、推理与工具调用能力。采用混合专家(Mixture-of-Experts)架构,结合高效训练策略,专注提升工具调用、网页浏览、软件工程、前端编程等关键场景表现。支持最长 128k 上下文,具备思考模式与即时响应模式,灵活适配复杂任务与高效调用。

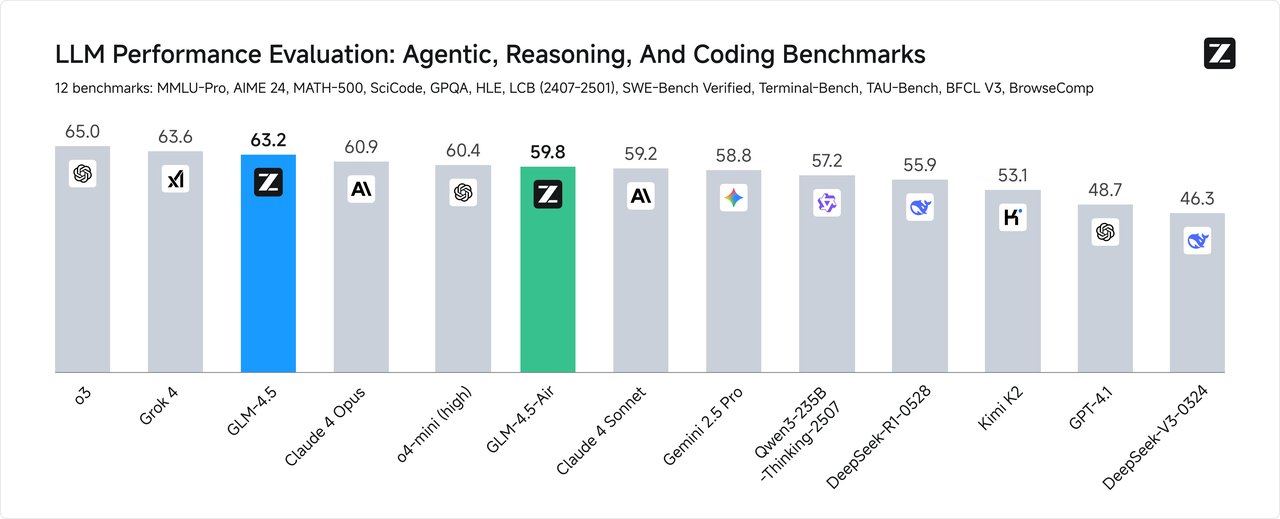

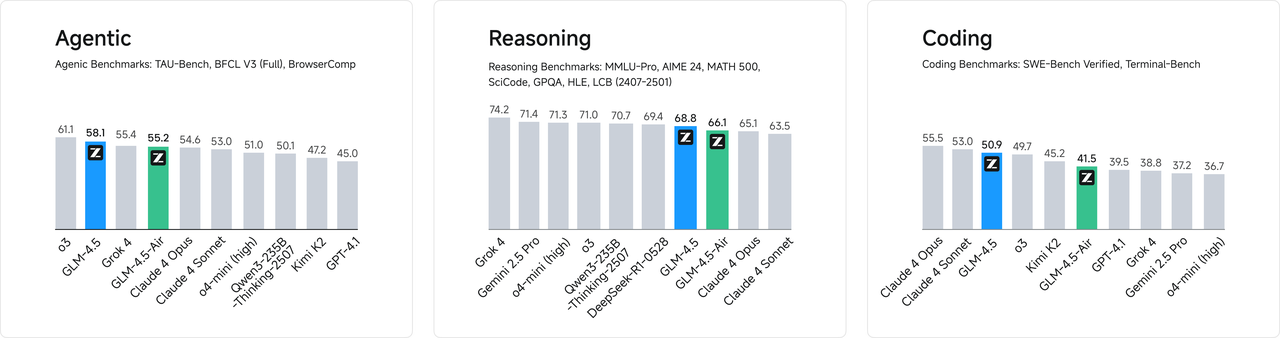

在12个维度的基准评测中,GLM-4.5 取得了全球模型第二、国产模型第一,开源模型第一:

极客智坊已支持智谱清言最新发布的 GLM 4.5 系列模型,包括开源模型和商业模型,GLM-4.5 系列是智谱清言面向智能体时代打造的最新旗舰模型,全面升级理解、推理与工具调用能力。采用混合专家(Mixture-of-Experts)架构,结合高效训练策略,专注提升工具调用、网页浏览、软件工程、前端编程等关键场景表现。支持最长 128k 上下文,具备思考模式与即时响应模式,灵活适配复杂任务与高效调用。

在12个维度的基准评测中,GLM-4.5 取得了全球模型第二、国产模型第一,开源模型第一:

欢迎体验👉

欢迎体验👉

- GLM-4.5 体验入口:智谱清言全新旗舰模型,国产综合评测第一,推理、代码、智能体等综合能力出色。

- GLM-4.5-Air 体验入口:智谱清言全新旗舰模型轻量版,极具性价比,支持混合推理模式切换。

- GLM-4.5-Air 免费版体验入口:GLM-4.5-Air 限时免费版。

- GLM-4.5-Flash 体验入口:智谱清言全新旗舰模型免费版,全面升级推理、代码与工具调用能力。

需要注意的是,官方限定 GLM-4.5 系列模型的并发量很低,极客智坊提供了远高于官方的并发量,保证你在高并发场景下的使用体验(GLM-4.5-Flash除外)。

2025.07.22 支持 Qwen3-235B-A22B 2507

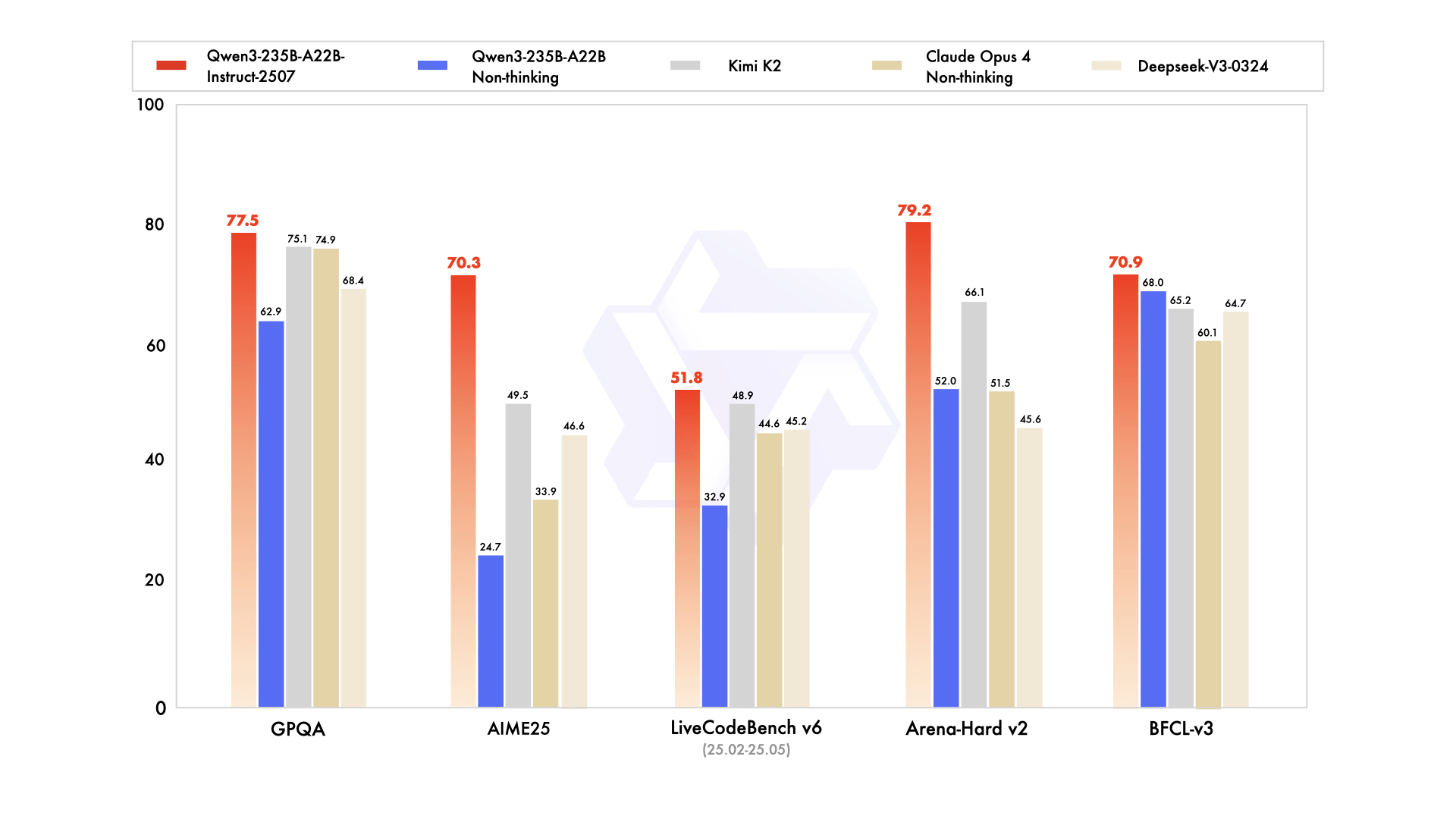

极客智坊已支持 Qwen3-235B-A22B 2507 模型,这是 Qwen3 系列最新发布的模型,具有更强的推理能力和更长的上下文窗口(262K),相较于基础版,该版本在知识覆盖、长上下文推理、编码基准测试以及与开放式任务对齐方面取得了显著提升。

该模型在多个基准测试中表现出色,以下场景表现超过 Kimi K2、DeepSeek V3 以及 Claude Opus 4:

极客智坊已支持 Qwen3-235B-A22B 2507 模型,这是 Qwen3 系列最新发布的模型,具有更强的推理能力和更长的上下文窗口(262K),相较于基础版,该版本在知识覆盖、长上下文推理、编码基准测试以及与开放式任务对齐方面取得了显著提升。

该模型在多个基准测试中表现出色,以下场景表现超过 Kimi K2、DeepSeek V3 以及 Claude Opus 4:

但价格更便宜,比 DeepSeek V3 还要便宜,欢迎体验👉

你还可以通过极客智坊提供的模型代理 API 在自己的应用中集成对 Qwen3-235B-A22B 2507 模型的调用,不过目前线路比较少,建议以体验为主,不推荐在生产环境使用:

但价格更便宜,比 DeepSeek V3 还要便宜,欢迎体验👉

你还可以通过极客智坊提供的模型代理 API 在自己的应用中集成对 Qwen3-235B-A22B 2507 模型的调用,不过目前线路比较少,建议以体验为主,不推荐在生产环境使用:

2025.07.11 支持 xAI Grok-4

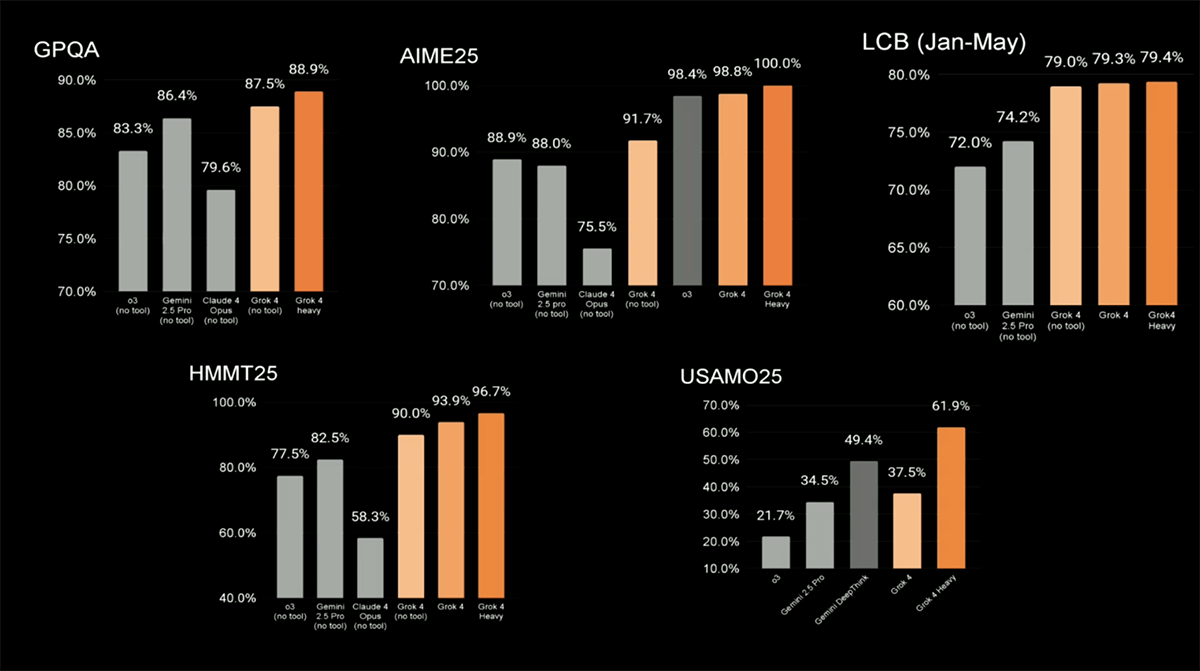

极客智坊已支持 xAI 最新发布的推理模型 Grok-4 —— xAI 迄今为止最强大的模型,具有更高的推理能力和更长的上下文窗口。它在多个基准测试中表现出色:

极客智坊已支持 xAI 最新发布的推理模型 Grok-4 —— xAI 迄今为止最强大的模型,具有更高的推理能力和更长的上下文窗口。它在多个基准测试中表现出色:

马斯克声称该模型在学术领域已经超越人类。“在学术问题方面,Grok 4 在每个科目上都优于博士水平,无一例外,”他说道。你可以在极客智坊体验这一最新模型👉

你还可以通过极客智坊提供的模型代理 API 在自己的应用中集成对 Grok-4 模型的调用,为降低开发者 API 调用成本,极客智坊提供了多个不同折扣的低价渠道,最低1折即可使用:

马斯克声称该模型在学术领域已经超越人类。“在学术问题方面,Grok 4 在每个科目上都优于博士水平,无一例外,”他说道。你可以在极客智坊体验这一最新模型👉

你还可以通过极客智坊提供的模型代理 API 在自己的应用中集成对 Grok-4 模型的调用,为降低开发者 API 调用成本,极客智坊提供了多个不同折扣的低价渠道,最低1折即可使用:

你可以前往极客智坊模型广场查看了解更多细节,关于 API 调用示例,请参考推理模式对话。

你可以前往极客智坊模型广场查看了解更多细节,关于 API 调用示例,请参考推理模式对话。

2025.07.09 支持 GLM-4.1V-Thinking 系列模型

极客智坊已支持智谱清言最新发布的视觉推理模型 GLM-4.1V-Thinking 系列模型,该系列是目前已知 10B 尺寸级别中性能最强的视觉推理模型。它在图表/视频理解、前端编码、GUI任务等核心能力达到全面新SOTA,并引入思维链推理机制,显著提升模型在复杂场景中的回答精准度与可解释性:

极客智坊已支持智谱清言最新发布的视觉推理模型 GLM-4.1V-Thinking 系列模型,该系列是目前已知 10B 尺寸级别中性能最强的视觉推理模型。它在图表/视频理解、前端编码、GUI任务等核心能力达到全面新SOTA,并引入思维链推理机制,显著提升模型在复杂场景中的回答精准度与可解释性:

| 模型版本 | 定位 | 价格 | 输入模态 | 输出模态 | 上下文窗口 |

|---|---|---|---|---|---|

| GLM-4.1V-Thinking-Flash | 免费版 | / | 视频、图像、文档 | 文本 | 64K |

| GLM-4.1V-Thinking-FlashX | 高并发版 | 2元 / 百万Tokens | 视频、图像、文档 | 文本 | 64K |

- 图文理解:精准识别并综合分析图像与文本信息;

- 数学与科学推理:支持持复杂题解、多步演绎与公式理解;

- 视频理解:具备时序分析与事件逻辑建模能力;

- GUI 与网页智能体任务:理解界面结构,辅助自动化操作;

- 视觉锚定与实体定位:语言与图像区域精准对齐,提升人机交互可控性。

你可以前往极客智坊模型广场查看了解更多细节,关于 API 调用示例,请参考推理模式对话。

你可以前往极客智坊模型广场查看了解更多细节,关于 API 调用示例,请参考推理模式对话。

2025.07.06 支持 OpenAI 深度研究模型

极客智坊已支持 OpenAI 最新发布的深度研究模型 o3-deep-research 和 o4-mini-deep-research:

极客智坊已支持 OpenAI 最新发布的深度研究模型 o3-deep-research 和 o4-mini-deep-research:

- o3-deep-research 是 OpenAI 最先进的深度研究模型,旨在处理复杂的多步骤研究任务。它能够搜索并整合来自互联网以及通过 MCP 连接器导入自有数据中的信息。

- o4-mini-deep-research 是更快、更经济的深度研究模型,非常适合处理复杂、多步骤的研究任务。它能够搜索和整合来自互联网以及通过 MCP 连接器导入自有数据中的信息。

你可以前往极客智坊模型广场查看了解更多细节,关于 Response API 调用,请参考对应的 API 手册。

你可以前往极客智坊模型广场查看了解更多细节,关于 Response API 调用,请参考对应的 API 手册。

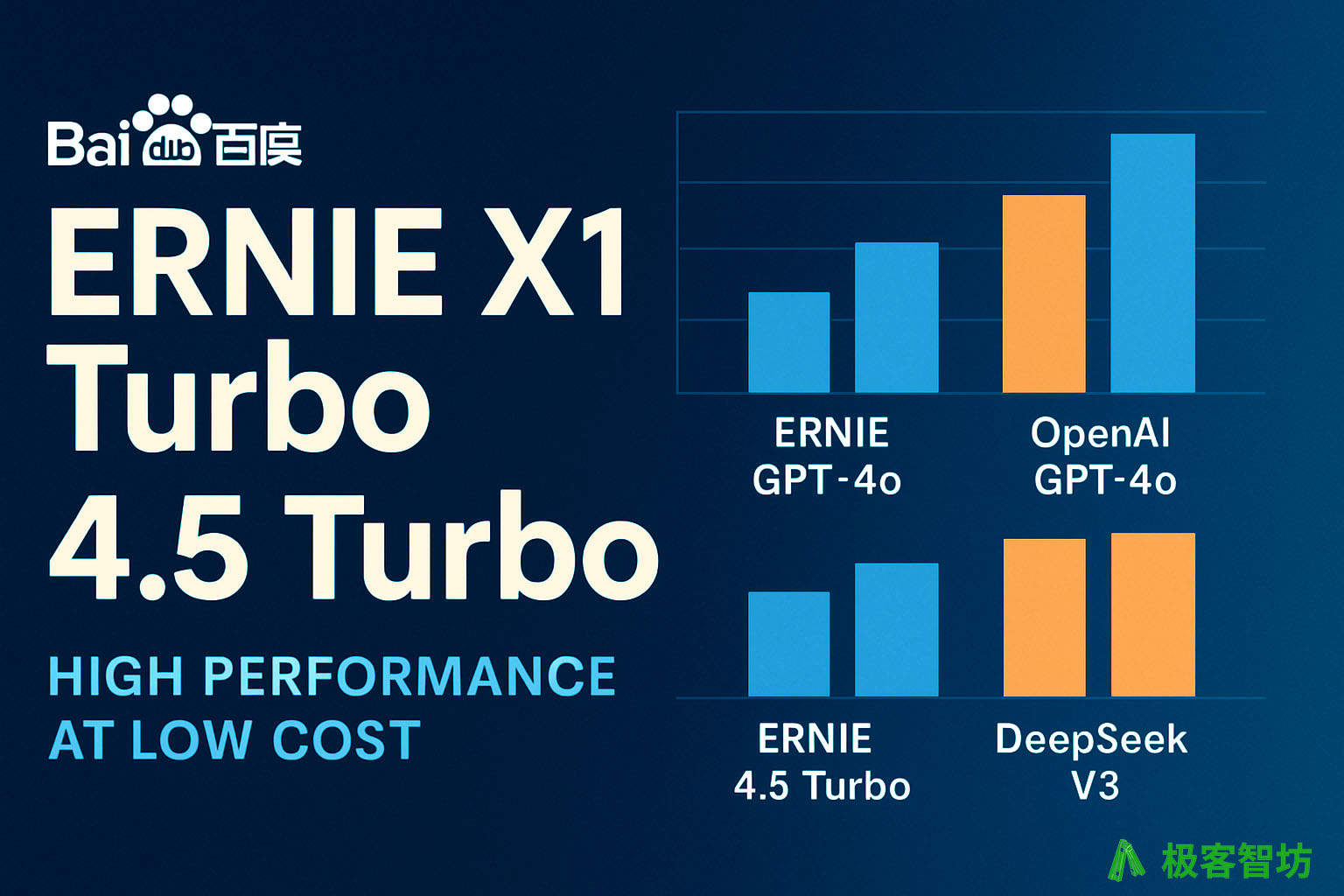

2025.07.01 支持百度 ERNIE 4.5 & X1 新模型

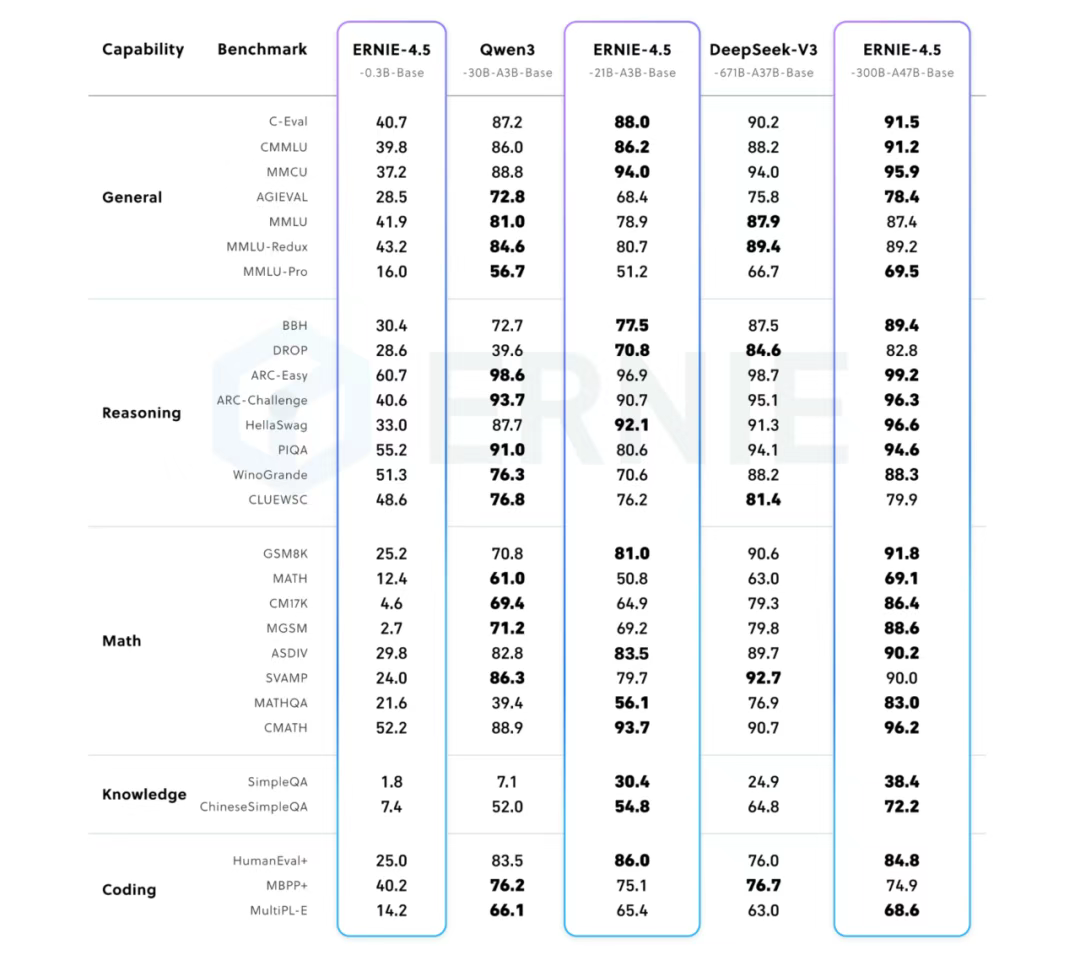

极客智坊已支持百度最新发布的 ERNIE 4.5 & X1 系列新模型,包括开源模型和商业模型,ERNIE 4.5 系列模型均使用飞桨深度学习框架进行高效训练、推理和部署。在大语言模型的预训练中,模型 FLOPs 利用率(MFU)达到 47%。实验结果显示,该系列模型在多个文本和多模态基准测试中达到 SOTA 水平,在指令遵循、世界知识记忆、视觉理解和多模态推理任务上效果尤为突出:

极客智坊已支持百度最新发布的 ERNIE 4.5 & X1 系列新模型,包括开源模型和商业模型,ERNIE 4.5 系列模型均使用飞桨深度学习框架进行高效训练、推理和部署。在大语言模型的预训练中,模型 FLOPs 利用率(MFU)达到 47%。实验结果显示,该系列模型在多个文本和多模态基准测试中达到 SOTA 水平,在指令遵循、世界知识记忆、视觉理解和多模态推理任务上效果尤为突出:

欢迎体验👉

开源模型

欢迎体验👉

开源模型

- ERNIE-4.5-0.3B 体验入口:ERNIE-4.5-0.3B 是 dense 结构的对齐开源模型

- ERNIE-4.5-21B-A3B 体验入口:ERNIE-4.5-21B-A3B 是 MoE 结构的对齐开源模型,总参数 21B,激活 3B

- ERNIE-4.5-VL-28B-A3B 体验入口:ERNIE-4.5-VL-28B-A3B 是多模态 MoE 的开源对话模型,总参数 28B,激活 3B

- ERNIE-4.5-300B-A47B 体验入口:EERNIE-4.5-300B-A47B 是 ERNIE-4.5 开源对话模型,总参数 300B,激活 47B

- ERNIE-4.5-VL-424B-A47B 体验入口:ERNIE-4.5-VL-424B-A47B 是 ERNIE-4.5 开源多模态模型,总参数 424B,激活 47B

- ERNIE-4.5-Turbo-32K 体验入口:文本创作、知识问答等能力提升显著,输出长度及整句时延相较ERNIE 4.5有所增加

- ERNIE-4.5-Turbo-128K 体验入口:模型能力全面提升,更好满足多轮长历史对话处理、长文档理解问答任务

- ERNIE-4.5-Turbo-VL-32K 体验入口:图片理解、创作、翻译、代码等能力显著提升,首次支持32K上下文长度

- ERNIE-4.5-Turbo-VL-Preview 体验入口:图片理解、创作、翻译、代码等能力显著提升,支持128K上下文长度

- ERNIE-X1-Turbo-32K 体验入口:与 ERNIE-X1-32K 相比,模型效果和性能更好

关于 ERNIE 4.5 & X1 模型价格信息,你可以前往极客智坊模型广场进行查看了解更多细节。

关于 ERNIE 4.5 & X1 模型价格信息,你可以前往极客智坊模型广场进行查看了解更多细节。